私たちが日々当たり前のように行っている「検索」という行為が、今、過去最大級の転換期を迎えています。これまでのインターネット検索は、知りたいキーワードを入力し、検索エンジンが提示した青いリンクのリストから、自分に合いそうなページを選んでクリックし、その先のページで情報を探すという能動的な作業でした。しかし、ChatGPTやGoogleのAI Overviews(旧SGE)、PerplexityといったAI検索エンジンの台頭により、このプロセスが根底から覆されようとしています。

ユーザーはもはや「リンクを探す」のではなく、「AIに質問して、直接答えを得る」という体験を求めています。AIは膨大なインターネット上の情報から最適な回答を生成し、まるでチャットをしているかのように即座に提示します。この変化は、ユーザーにとっては非常に便利で効率的なものです。しかし、情報を発信する側の企業や店舗にとっては、死活問題になりかねない大きな変化を意味します。

これまでのホームページは、検索結果に表示されさえすれば、ユーザーが訪問してくれる可能性がありました。しかし、AI検索が主流となるこれからの時代においては、AIが「回答」を生成する際に、自社のホームページの情報が参照されなければ、ユーザーの目に触れることすらなくなってしまいます。つまり、人間にとって魅力的であると同時に、AIにとっても「理解しやすく、信頼できる情報源」であるかどうかが、ホームページの価値を決定づけることになります。

そこで今回は、AI検索時代に対応するための「GEO(生成エンジン最適化)」という新しい概念と、それを実現するための具体的な技術要件について、専門的な視点から深く掘り下げていきます。そして、この変化に対応するか否かで、企業のWeb集客が「勝者総取り」か「効果ゼロ」のいずれかに二極化していく厳しい未来予測についても触れていきます。これからホームページのリニューアルを検討されている事業担当者様にとって、重要な判断材料となるはずです。

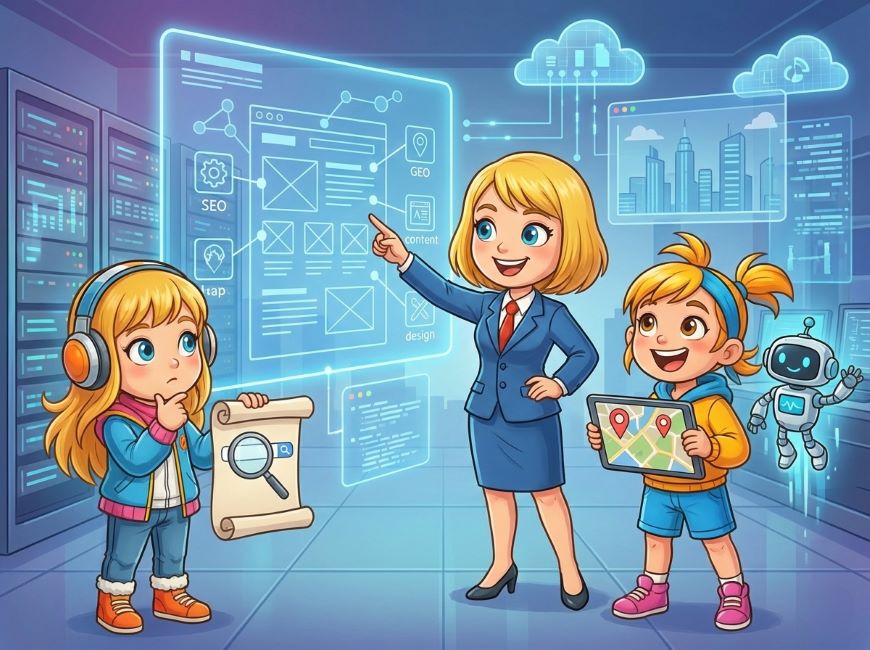

GEO(生成エンジン最適化)とは何か

SEO(Search Engine Optimization)という言葉は広く知られていますが、今後はそれに代わる、あるいは並走する概念として「GEO(Generative Engine Optimization)」への理解が必要になります。これは、生成AI検索エンジンに対して自社のコンテンツを最適化し、AIが生成する回答の中に自社のブランド名や商品を引用させるための施策を指します。

AIに「信頼できる情報源」として認識させること

従来のSEOは、特定のキーワードで検索された際に、自社のページを検索結果の上位に表示させることが最大の目的でした。検索エンジンのアルゴリズムに向けて、「このページは人気があります」「このページは関連性が高いです」とアピールする競争と言えました。

一方でGEOが目指すのは、検索順位の獲得だけではありません。AIがユーザーの質問に対して回答を作成する際、その情報の「引用元(ソース)」として選ばれることを目指します。現在のAI検索は、大規模言語モデル(LLM)をベースにしていますが、LLMは確率的に言葉を繋げているに過ぎません。そのため、AIは常に「事実に基づいた正確な情報」を外部のWebデータに求めています。これを「グラウンディング」と呼びますが、GEOの本質は、AIがグラウンディングを行う際に、自社のホームページを第一の参照先として選んでもらうための環境作りと言えます。

GEO AIによる概要に表示

AIに選ばれるためには、情報の正確性はもちろんのこと、誰が発信しているのかという権威性、そしてAIがデータを読み取りやすい構造になっているかどうかが問われます。これまでのように、小手先のテクニックでキーワードを埋め込んだだけのコンテンツは、AIに見透かされ、学習データとしての価値が低いと判断される可能性が高いです。AIに対して「このホームページの情報こそが、この分野における正解である」と認識させるための、技術的かつ本質的なアプローチが求められます。

検索結果における「ゼロクリック」の増加

GEOに取り組むべき最大の理由は、検索結果画面(SERPs)上でユーザーの目的が完結してしまう「ゼロクリック」現象の加速にあります。

例えば、「近くのおすすめのカフェ」と検索したとします。これまでは、検索結果に表示された「地域のおすすめカフェ10選」といったポータルサイトやブログ記事をクリックして情報を探していました。

しかし、AI検索においては、検索結果のトップにAIが生成した「おすすめのカフェ3選」とその特徴、地図、口コミの要約が直接表示されます。ユーザーはその情報だけで満足し、個別のホームページにアクセスすることなく、そのまま来店したり予約の電話をかけたりするようになります。

Google検索で「AIモード」が開始 AI Overviews(旧SGE)との違い

このように、ホームページへのアクセス数(トラフィック)自体は減少する傾向にあります。しかし、これを悲観するだけでは事業は成り立ちません。重要なのは、アクセス数が減ったとしても、AIが生成する回答の中に自社が含まれているかどうかです。もしAIの回答に含まれていなければ、そのユーザーにとって自社は存在しないも同然となってしまいます。

逆に言えば、ゼロクリック検索の結果として表示されるAIの回答エリア(スナップショット)に自社の情報が掲載されれば、ホームページへの遷移はなくても、ブランドの認知や実店舗への集客といった実利を得ることができます。クリックされることを前提とした従来のWebマーケティング指標(PV数やセッション数)から脱却し、AIによる「参照数」や「指名検索数」といった新しい指標で成果を測る必要が出てきます。

従来のSEOとGEOの決定的な違い

SEOとGEOは似て非なるものです。SEOは「検索窓にキーワードを入れる人間」と「ランキングを決めるアルゴリズム」の間の調整作業でした。そこには、ある程度の攻略法や正解が存在していました。しかしGEOの相手は「文脈を理解し、回答を生成するAI」です。

AIは、単一のページの情報だけで判断するのではなく、サイト全体の専門性、外部からの評価、さらには画像や動画といった非テキスト情報までを含めて総合的に判断します。これを「マルチモーダルな理解」と呼びます。したがって、GEOにおいては、特定のページだけを修正すれば良いというものではありません。ドメイン全体、あるいは事業活動全体が、デジタル空間上でどのように表現されているかという「エンティティ(実体)の信頼性」が問われることになります。

SEOが「テクニック」の比重が高かったとすれば、GEOは「オーセンティシティ(本物であること)」と「テクニカルな伝達力」の両方が高度に求められる総力戦です。コンテンツの中身が伴っていないのに技術だけでどうにかしようとしても通用しませんし、逆に素晴らしいコンテンツを持っていても、技術的にAIに伝わらなければ無視されてしまいます。この両輪を回すことが、これからのホームページリニューアルの基本戦略となります。

AI検索時代(GEO)に対応の基本的な要点

ここからは、概念論を超えて、実際にホームページをリニューアルする際にどのような技術を実装すべきか、専門的な領域に踏み込んで解説します。AI検索エンジン最適化において求められるのは、検索エンジンに対して単にキーワードを伝えることではありません。AIが学習・推論しやすい形式でデータを提供し、なおかつテキストと視覚情報に矛盾がない「実態のある信頼性」を技術的に証明する必要があります。

多くのWeb制作者や事業者がまだ十分に対応しきれていない、しかし確実に対応しなければ差がつく領域について、詳しく見ていきます。

マルチモーダルAIを意識した視覚情報とテキストの一致性

これまでのSEOでは、画像に対する対策といえば、ファイル名をわかりやすくする、あるいは「alt属性」で代替テキストを入れるといったことが主でした。

しかし、現在主流となっているAIモデル(GoogleのGeminiやOpenAIのGPT-5など)は、画像そのものをピクセル単位で解析し、そこに何が写っているか、どのような雰囲気か、品質はどうかを人間と同等以上の精度で判断できるようになっています。

これを「マルチモーダルAI」と呼びます。この進化は、ホームページ制作において非常に重要な意味を持ちます。

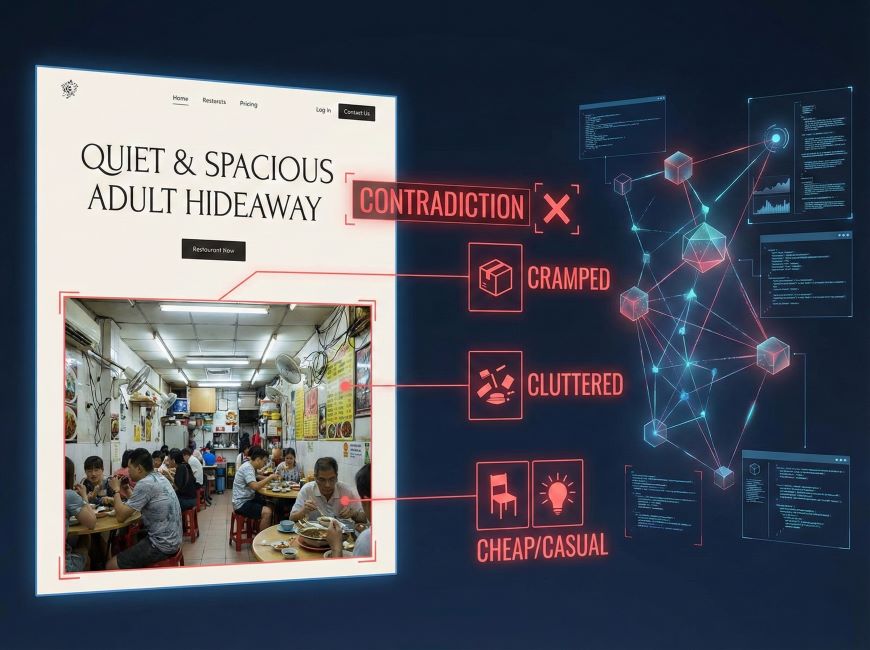

画像解析による事実確認とコンテキストの照合

AIは、ページ内のテキスト情報と、そこに掲載されている画像情報の整合性をチェックしています。これを「グラウンディング(根拠付け)」のプロセスとして行います。

例えば、ある飲食店のホームページで、テキストでは「静かで落ち着いた、広々とした大人の隠れ家」と謳っていたとします。

しかし、掲載されている店内写真が、狭い画角で撮影されており、物が雑然と置かれ、照明も明るすぎてチープな印象を与えるものだった場合、AIはどう判断するでしょうか?

高度な画像解析能力を持つAIは、写真から「狭い」「雑多」「大衆的」といった特徴を抽出します。

その結果、テキストの主張(広々とした大人の空間)と画像の事実(狭くて大衆的)が矛盾していると判断し、このページの情報全体の信頼性を低く見積もる可能性があります。つまり、「言っていることと見せていることが違う」とAIに見抜かれてしまうわけです。

したがって、これからのリニューアルにおいては、写真は単なる賑やかしや装飾ではありません。テキストで主張している自社の強みや特徴を、視覚的に証明するための「証拠データ」として扱う必要があります。

「広々とした」と書くならば、広角レンズで空間の広がりがわかる写真を掲載しなければなりません。「職人の手仕事」を強調するならば、実際に作業している手元の高解像度な写真を掲載し、AIに「確かに手仕事が行われている」と認識させる必要があります。

エンティティとしての被写体の明確化

また、AIは写真に写っている物体や人物が、そのページのトピックや事業主体(エンティティ)と本当に関連しているかどうかも見ています。

よくある失敗例として、「スタッフ紹介」や「お客様対応」のページに、無料の素材サイトからダウンロードした外国人モデルや、どこかで見たことのある日本人モデルの写真を使用しているケースがあります。人間が見ても「これはイメージ写真だな」とわかりますが、AIはよりシビアに判断します。Web上の膨大なデータを学習しているAIは、その写真が他の何千ものサイトで使われている「汎用的な素材」であることを即座に特定します。

その結果、AIはその画像を「この企業固有の情報ではない」と分類し、そのページや企業の独自性(オリジナリティ)の評価を下げる要因になりかねません。逆に、画質が多少劣っていたとしても、実際の店舗で、実際のスタッフが働いている独自の写真を掲載することは、AIに対して「この企業は実在し、この場所で活動している」という強力なシグナルを送ることになります。

特に代表者や専門家のプロフィール写真においては、その人物が他の信頼できるメディア(ニュースサイトや業界団体のページなど)に掲載されている写真と、顔の特徴量などが一致するかどうかの照合が行われる段階に来ています。これにより、AIはその著者が架空の人物ではなく、実在する権威ある人物であることを確認します。リニューアルの際は、素材写真に頼ることをやめ、コストをかけてでも自社の「リアル」を撮影し、掲載することが、GEOにおける重要な技術要件の一つとなります。

AI検索時代(GEO)に対応するためのWeb制作技術的要件と実装詳細

先ほどまでは、AIが人間のように「画像」を見て判断しているという点について解説しました。しかし、AIボット(クローラー)の基本動作は、依然としてHTMLコードの解析にあります。ここでは、AIにとって「読みやすいコード」とは何か、そして情報を正しくデータベースに格納してもらうための設計思想について掘り下げます。

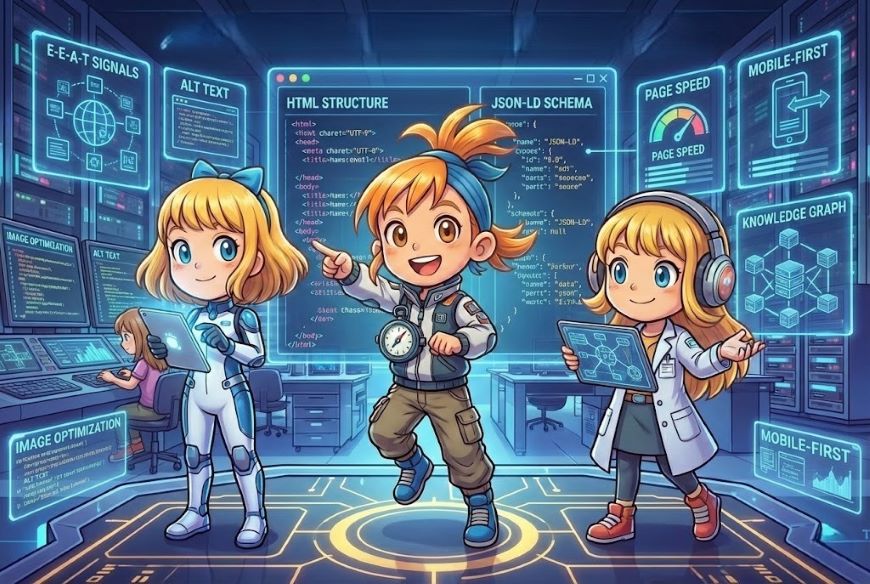

AIの学習効率を高めるセマンティックなHTML構造とアクセシビリティ

AIボットは、私たちがブラウザで見ているような綺麗なデザインされた画面を見ているわけではありません。彼らが見ているのは、HTMLというソースコードの文字列です。このコードの記述方法が、AIの理解度を大きく左右します。実は、この「AIへの配慮」は、視覚障がい者の方が利用するスクリーンリーダー(画面読み上げソフト)への配慮と、技術的にほぼ同じ意味を持ちます。

セマンティックHTML Webページの論理構造の明確化で「意味」を構築

アクセシビリティツリーとAIの理解度

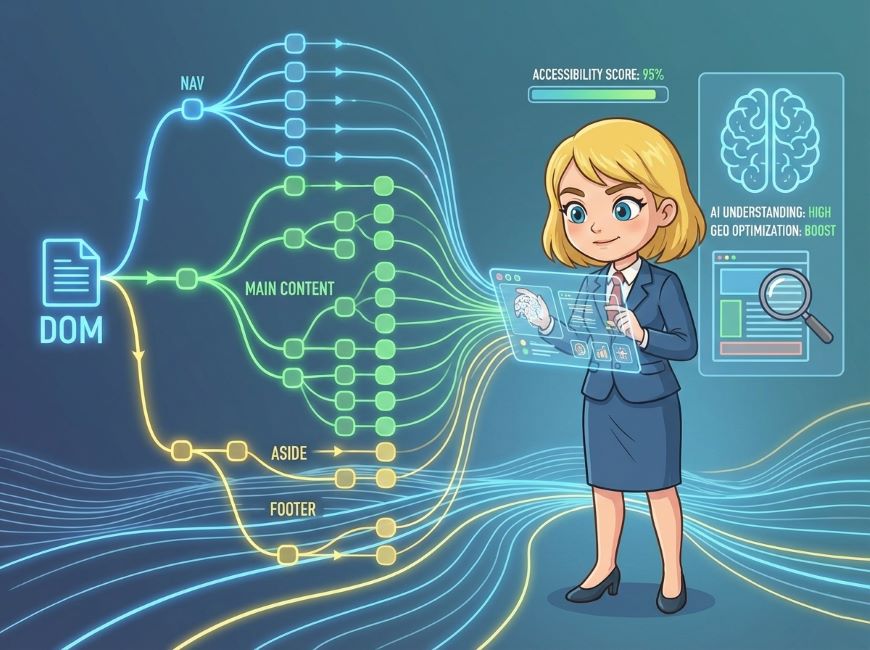

Webアクセシビリティへの対応は、もはや倫理的な観点だけでなく、GEOにおける強力な技術施策となります。AIはページの内容を理解するために、DOM(Document Object Model)を解析し、どこがナビゲーションで、どこが本文で、どこが補足情報なのかを分類しようとします。

このとき、単に見た目を整えるためだけのdivタグを多用していると、AIは情報の重要度を判断できません。一方で、<header>、<nav>、<main>、<article>、<section>、<aside>といったHTML5のセマンティックタグ(意味を持つタグ)を正しく使い分けていれば、AIは迷うことなく情報の構造を把握できます。例えば、<nav>タグの中にあるリンクはメニューであるためコンテンツの評価対象外にする、<main>タグの中にある記述こそがこのページの主題である、といった判断を効率的に行えるようになります。

また、WAI-ARIA(Web Accessibility Initiative – Accessible Rich Internet Applications)の属性設定も有効です。これは、HTMLだけでは表現しきれない役割や状態を定義するものです。これらを適切に実装することで、スクリーンリーダーだけでなく、AIに対しても「ここは重要な警告文である」「ここはタブの切り替えコンテンツである」といった文脈を正確に伝えることができます。誰にでも優しいホームページは、AIにとっても優しいホームページなのです。

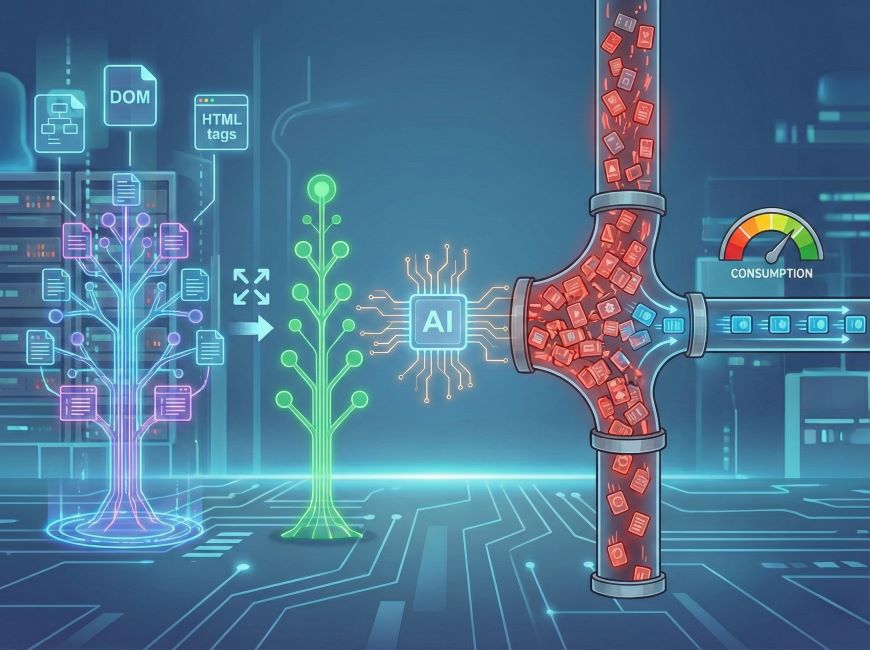

DOM構造の軽量化とトークン消費の最適化

AIモデルが一度に処理できる情報量には限りがあります。これを「トークンウィンドウ」や「コンテキストウィンドウ」と呼びます。もし、ホームページのソースコードが非常に冗長で、意味のないdivタグが何重にも入れ子になっていたり(いわゆるdivスープ状態)、使用していないJavaScriptのコードが大量に含まれていたりすると、AIにとってのノイズが増大します。

最悪の場合、AIはページの途中で読み込みを中断し、重要なコンテンツ部分に到達する前に離脱してしまうかもしれません。これは、せっかくの良いコンテンツが学習されないことを意味します。リニューアルにおいては、デザイナーやフロントエンドエンジニアに対し、見た目の再現だけでなく「ソースコードの美しさ」を要求することが重要です。不要なタグを削ぎ落とし、テキスト情報の比率を高めたスリムで堅牢なHTML構造を構築することは、AIのトークン消費を節約し、より多くの情報を学習してもらうための重要なテクニックです。

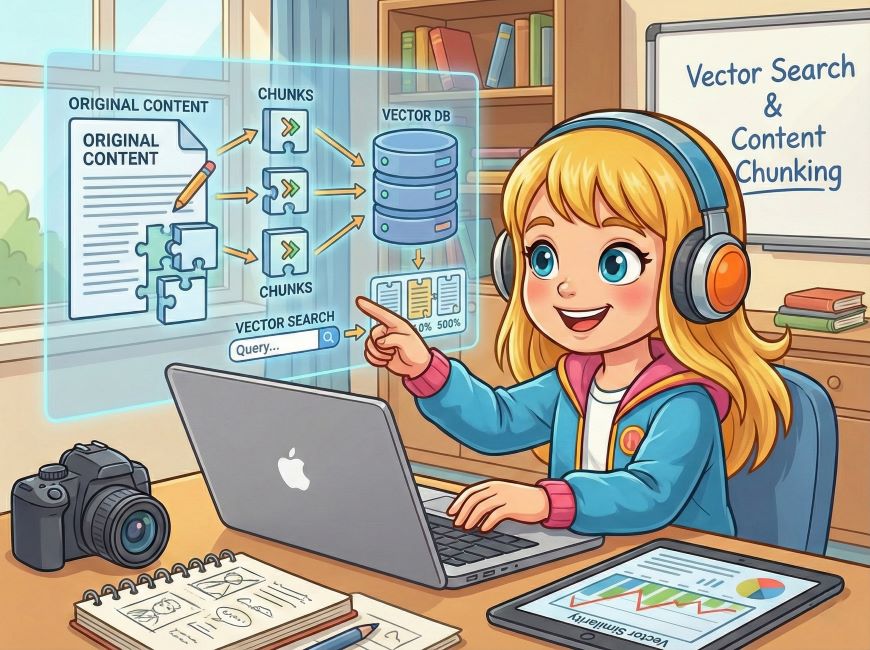

ベクトル検索に対応したコンテンツのチャンク化設計

近年の検索システムは、キーワード検索から「ベクトル検索」へと移行しています。これは、言葉を数値(ベクトル)に変換し、意味の距離が近い情報を探し出す技術です。AIはこの技術を使って、ユーザーの曖昧な質問に対しても適切な回答を見つけ出します。この仕組みに対応するためには、文章の書き方や構成にも変化が必要です。

意味の切れ目を明確にする文章構成

AIは長い文章をそのまま丸暗記するのではなく、「チャンク」と呼ばれる意味のかたまりごとに分解してデータベースに保存します。したがって、ホームページ上の文章も、AIが切り取りやすいサイズで構成されていることが望ましいです。

ダラダラと続く長文は、どこで意味が区切れるのかAIが判断しづらく、結果として誤った文脈で引用されるリスクがあります。これを防ぐためには、ひとつの見出し(h2やh3)に対して、ひとつのトピックを完結させる構成を意識します。「結論・理由・具体例・まとめ」という論理構造を、ひとつのセクション内で完結させるのです。そうすることで、AIはそのセクション全体をひとつの「回答ブロック」として認識し、ユーザーからの質問に対してそのまま引用しやすくなります。

文脈依存を減らした自立的な記述

人間が文章を読むとき、前後の文脈から「これ」「それ」「あの件」といった代名詞が何を指しているかを自然に理解します。しかし、AIが情報をチャンク(断片)として切り出して保存した際、代名詞が含まれていると、その断片だけでは意味が通じなくなってしまいます。

例えば、「それは非常に効果的です」という文だけが切り取られた場合、何が効果的なのか全くわかりません。これでは検索結果の回答として採用されません。

GEOを意識したライティングでは、代名詞の使用を極力控え、「このSEO施策は~」「当該製品の耐久性は~」といった具合に、主語や目的語を省略せずに記述する「自立した文章(Self-contained content)」が求められます。

一見するとくどい文章に見えるかもしれませんが、AIにとっては非常に論理的で扱いやすいデータとなります。これはテクニカルライティングの領域ですが、これからのWeb担当者が身につけるべき重要なスキルです。

AIとの共通言語「構造化データ(JSON-LD)」の標準実装

ここまでのHTML構造や文章構成は、あくまでAIに「推測」させるための手助けでした。しかし、AIに対して推測ではなく「確実な意味」を直接伝える手段があります。それが構造化データです。GEOにおいて、この実装はもはやオプションではなく、必須の要件と言えます。

検索エンジンへの翻訳機としての役割

通常のHTMLで「株式会社ファンフェアファンファーレ」と書いても、検索エンジンにとっては単なる文字列に過ぎません。それが会社名なのか、本のタイトルなのか、ただの造語なのかを確信を持って判断するのは難しい場合があります。

そこで、検索エンジンが理解できる共通言語である「Schema.org」の語彙を使い、「これは組織(Organization)の名前(name)です」とタグ付けしてあげる必要があります。これにより、AIは曖昧さを排除して情報を理解できるようになります。以前はHTMLタグに直接埋め込むMicrodata形式も使われていましたが、現在は管理がしやすく、ページの表示速度への影響も少ない「JSON-LD」という形式で記述するのが世界的な標準となっています。

構造化データ(JSON-LD)実装の種類と詳細

構造化データには、組織情報やパンくずリストといった基本的なものから、求人情報、イベント情報、Q&A、商品情報など、多岐にわたるタイプが存在します。自社の事業内容に合わせて最適なタイプを選び、正確に記述することで、リッチリザルト(検索結果での特別な表示)を獲得できる可能性も高まります。

このJSON-LDを用いた具体的なコードの書き方や、どのタイプを実装すべきかといった技術的な詳細については、以下の記事で徹底的に解説しています。リニューアルの実装フェーズに入る前に、エンジニアの方と合わせて必ずご確認ください。

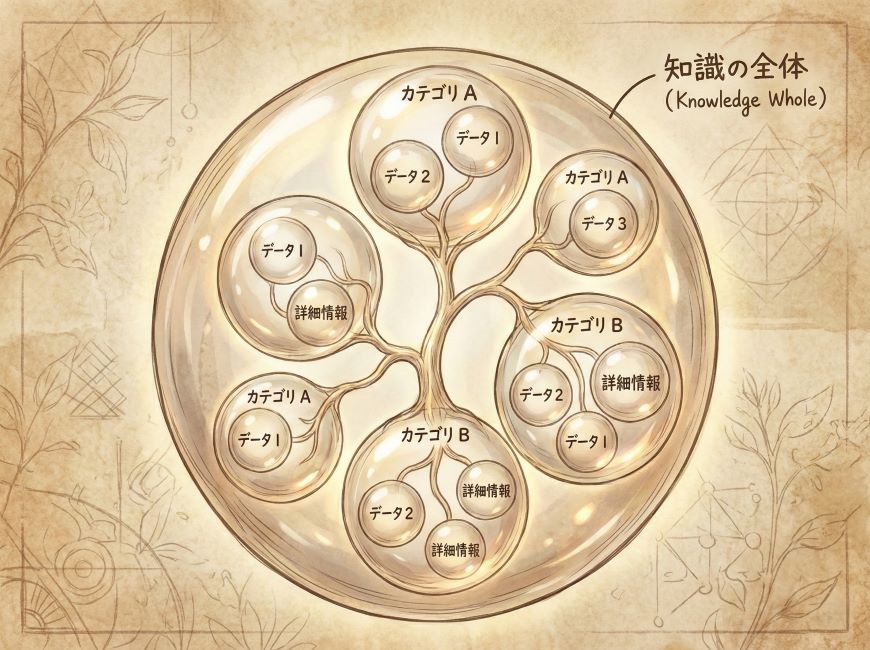

高度な構造化データによるナレッジグラフへの接続

Schema.orgを用いた構造化データは、AIに対して「これは何の情報か」をHTMLとは別のレイヤーで直接説明するための言語です。多くのホームページでは、基本的な「組織情報」や「パンくずリスト」程度しか実装されていませんが、AI検索時代にはより高度で緻密な実装が求められます。

ネスト構造を用いた情報の階層化

情報は単独で存在するのではなく、常に関連し合っています。構造化データでも、この「関連性」を表現することが重要です。例えば、「会社情報」と「商品情報」と「代表者情報」をそれぞれ別々に記述するのではなく、入れ子(ネスト)構造にして記述します。

「会社(Organization)」の中に「創設者(founder)」が含まれ、その創設者が「人物(Person)」であり、その人物が書いた「記事(Article)」があり、その記事の中で「商品(Product)」について言及している。このように記述することで、AIはそれぞれのデータがバラバラの点ではなく、意味のある線でつながった知識体系として理解します。この文脈情報こそが、AIが回答を生成する際の確信度を高める要素となります。

sameAsプロパティによるエンティティの紐付け

自社のホームページ内だけで情報を完結させず、外部の信頼できる情報と自社を紐付けることも重要です。構造化データのsameAsプロパティを使用して、自社の公式SNSアカウント、Wikipediaのページ、国税庁の法人番号公表サイト、あるいは業界団体の会員リストページなどへのリンクを記述します。

AIは「このホームページが主張している株式会社A」と「世の中で認知されている株式会社A」が同一の存在(エンティティ)であるかを確認しようとします。sameAsプロパティによって、信頼性の高い外部サイトと明確にリンクさせることで、AIの疑念を晴らし、ナレッジグラフ(Googleなどが持つ巨大な知識データベース)上での自社の位置付けを強固にすることができます。これは、なりすましや偽サイトとの差別化を図る上でも非常に有効な手段です。

AIボットに対する制御とクロールバジェットの最適化

最後に、AI検索エンジンが情報を収集するために使うロボット(クローラー)への技術的な対応について触れます。これまでのGoogleのクローラー(Googlebot)だけでなく、ChatGPTの「GPTBot」や、その他のAIモデルのクローラーが頻繁に訪れるようになっています。

robots.txtによるAIクローラーの制御

すべてのAIクローラーを無条件に受け入れることが、必ずしも正解とは限りません。中には、コンテンツを学習データとして吸い上げるだけで、検索結果には参照元として表示しないような、質の低いAIやスクレイピングボットも存在します。サーバーの負荷を軽減し、セキュリティを保つためにも、robots.txtを用いてクローラーの選別を行う戦略が必要です。

一方で、GoogleやBing、Perplexityなどの主要な検索系AIに対しては、確実にクロールできるように設定しなければなりません。不用意にすべてのボットをブロックしてしまい、AI検索の世界から消えてしまう事故も起きています。リニューアルの際には、どのボットを許可し、どのボットを拒否するかというポリシーを策定し、技術的に正しく設定する必要があります。

HTTPヘッダーによる鮮度情報の提供

AIは常に最新の情報を求めています。情報がいつ更新されたのかをAIに伝えるために、HTML上の日付表示だけでなく、サーバーが返すHTTPヘッダーの情報も重要になります。Last-Modified(最終更新日時)やETagといったヘッダー情報を適切に出力することで、AIはコンテンツの鮮度を正確に把握できます。

もし、CMSの仕組み上、これらのヘッダーが正しく出力されていない場合、AIはページの内容が変わっていないと誤認し、再クロールの頻度を下げてしまうかもしれません。あるいは、数年前の古い情報のままだと判断され、最新のトピックに関する回答候補から除外される可能性もあります。システムの裏側の地味な設定ですが、情報の鮮度を証明するためには欠かせない要件です。

ホームページリニューアルにおける具体的な実装ポイント

先ほどまでは、AIがどのように情報を理解するかという技術的な背景を解説しました。ここからは、それらを踏まえてホームページをリニューアルする際に、具体的にどのような作業や判断が必要になるのかを詳述します。これまでのSEO対策の常識が通用する部分と、GEOならではの新しい視点が必要な部分が混在しています。

ドメインパワーと運用履歴の継承

ホームページのリニューアルにおいて最も恐れるべきリスクは、これまで積み上げてきた検索エンジンからの評価を失ってしまうことです。AI検索時代において、ドメインの運用年数や過去の信頼性は、従来以上に重要な意味を持ちます。

301リダイレクトによる評価の完全移行

リニューアルに伴い、ページのURL構造やカテゴリ構成を変更することはよくあります。しかし、古いURLから新しいURLへの転送設定(301リダイレクト)を完璧に行わなければ、そのページが持っていた被リンクの評価や、検索エンジンが蓄積していた履歴データが全てリセットされてしまいます。

AIは、そのドメインが過去にどのような情報を発信し、どれだけのユーザーに支持されてきたかという長期的なコンテキストを重視します。URLが変わってアクセスできなくなることは、AIにとって「その情報源が消滅した」と認識されることと同義です。したがって、全ページのURL対照表を作成し、1ページたりとも漏らすことなくリダイレクト設定を行う作業は、リニューアルプロジェクトの中で最も慎重を期すべき工程です。

ドメイン変更は最終手段と心得る

時折、心機一転のためにドメイン(○○.comなどのアドレス)そのものを新しく取得し直そうとするケースがあります。しかし、GEOの観点からは、これはあまり推奨できません。新規ドメインは「生まれたばかりの赤ちゃん」であり、社会的な信用(Web上の権威性)がゼロの状態からスタートすることになるからです。

AI検索エンジンは、信頼性の高いドメインからの情報を優先的に引用します。何年も運用し、多くの被リンクを獲得している既存のドメインは、それだけで大きな資産です。どうしてもブランド名変更などでドメインを変えざるを得ない場合を除き、可能な限り既存ドメインを継続利用し、その「器」の中身を最新のGEO対応仕様に入れ替えるというアプローチが、最もリスクが少なく、成果が出やすい方法です。

表示速度とCore Web Vitalsの改善

ページの読み込み速度や、操作への反応速度を示す「Core Web Vitals(コアウェブバイタル)」は、Googleがランキング要因に組み込んでいる指標ですが、これはAI検索にとっても重要です。

クロール効率とインデックス速度の向上

人間にとって表示が遅いページはストレスですが、AIボットにとっても、反応が遅いサーバーや重いページは処理の負担になります。AIボットは世界中の膨大なページを巡回しなければならないため、応答の遅いサイトには長く滞在してくれません。

ページの表示速度を改善することは、AIボットに対して「このサイトは効率よく情報を収集できる健全なサイトです」とアピールすることになります。これにより、新しい記事を公開した際に、より早くAIに発見され、学習データベースに組み込まれる可能性が高まります。情報の鮮度が命となるトピックにおいては、この数時間、数日の差が、AIの回答に採用されるかどうかの分かれ道になることもあります。

画像の次世代フォーマットと遅延読み込み

具体的な高速化手法として、画像ファイルの最適化は必須です。従来のJPEGやPNGではなく、WebPやAVIFといった次世代フォーマットを採用することで、画質を維持したままファイルサイズを大幅に軽量化できます。これは、マルチモーダルAIが高画質な画像を解析するために必要なデータを確保しつつ、転送速度を落とさないためのバランス調整でもあります。

また、画面に表示されていない画像の読み込みを後回しにする「遅延読み込み(Lazy Loading)」の実装も標準的に行うべきです。ただし、ファーストビュー(最初に表示される画面領域)にあるメインビジュアルやロゴ画像まで遅延させてしまうと、逆に体感速度やLCP(最大視覚コンテンツの表示時間)が悪化します。どの画像を優先し、どれを遅延させるかという細やかな制御が、エンジニアの腕の見せ所となります。

画像の非同期デコード「decoding=”async”」と遅延読み込み「loading=”lazy”」

一次情報の発信と引用されやすいデータ作り

コンテンツの内容そのものについても、大きな転換が必要です。これまでのような「ネット上の情報をまとめただけの記事」や「当たり障りのない解説」は、AI検索時代にはほとんど価値を持ちません。なぜなら、情報の要約やまとめは、生成AI自身が最も得意とする作業だからです。AIが得意なことを人間が真似しても、勝てるわけがありません。

「ソース(情報源)」になるための独自性

AIが求めているのは、要約するための元ネタ、つまり「一次情報」です。自社で実施したアンケート調査の結果、長年の業務で蓄積された独自の統計データ、現場で撮影した事例写真、専門家としての独自の考察や提言など、他社のサイトには載っていないオリジナルの情報こそが、AIにとっての「ご馳走」です。

リニューアルにあたっては、各ページのコンテンツを見直し、「これはよそから借りてきた情報ではないか?」「自社独自の付加価値はどこにあるか?」を厳しくチェックする必要があります。もし一般的な情報しか載っていないのであれば、新たに取材を行ったり、社内のデータを掘り起こしたりして、独自情報を追加する工数を見込んでおくべきです。

データをAIが扱いやすい形式で提示する

せっかくの一次情報も、AIが読み取れなければ意味がありません。例えば、調査データを画像として貼り付けるだけでは不十分です。AIは画像内の文字も読めますが、確実性を高めるためには、HTMLの<table>タグを使って構造化された表としてデータを提示する方が親切です。

また、重要な結論や数値データは、文章の中に埋没させず、明確な見出しを付けたり、定義リスト(dl, dt, dd)を使ったりして、情報の所在をはっきりさせます。「○○の平均価格は5万円です」と文章で書くよりも、価格表として提示した方が、AIが「価格に関する質問」への回答を生成する際に、その数値をピックアップしやすくなります。このように、AIがデータを引用しやすいように「お膳立て」をしてあげる配慮が、GEOの効果を高めます。

専門性と権威性の可視化(E-E-A-Tの強化)

Googleが提唱するE-E-A-T(経験、専門性、権威性、信頼性)は、AI検索においても評価の根幹をなす概念です。誰が言っているか不明な情報よりも、その道のプロが発信している情報の方が、AIは回答として採用するリスクが低いと判断します。

著者情報と監修者の明確化

ブログ記事や解説コンテンツには、必ず執筆者や監修者のプロフィールを明記します。単に「編集部」とするのではなく、実名、顔写真、経歴、保有資格、過去の実績などを詳細に掲載します。そして、第2章で触れた構造化データを用いて、その人物と記事を紐付けます。

これにより、AIは「この記事は、○○という資格を持つ××氏によって書かれた、信頼性の高い情報である」と認識します。特に、医療、法律、金融といったYMYL(Your Money or Your Life)領域のホームページでは、この権威性の証明がなければ、AIの回答候補に挙がることすら難しいと考えてください。

運営会社情報の透明性

ホームページのフッターや会社概要ページの内容も充実させる必要があります。住所、電話番号、代表者名はもちろんのこと、所属団体、許認可番号、受賞歴、メディア掲載実績など、企業としての実在性と社会的な活動履歴を示す情報を網羅します。

これらの情報は、ナレッジグラフにおける企業の「エンティティ強度」を高めます。AIが「この会社は実在し、社会的に認知されており、怪しい組織ではない」と確信を持てるだけの材料を提供し続けることが、GEOの基盤となります。

二極化するWeb集客と経営判断

ここまで解説してきた通り、AI検索に対応するためのホームページリニューアルには、高度な技術的知識と、継続的なコンテンツ生成の労力が必要です。「ちょっとSEOを意識したブログを書く」といったレベルでは太刀打ちできないほど、求められる要件は複雑化しています。

この変化は、企業のWeb戦略を「やるなら徹底的にやる」か「潔く諦めるか」の二つに分断します。中途半端な対策が最も効果を生まない時代において、どのような経営判断を下すべきなのでしょうか。

積極的な投資を行う「勝者総取り」の道

ひとつ目の選択肢は、GEOを事業の柱として位置づけ、予算と人員を投じて徹底的に取り組む道です。これは、特定の分野において「日本で一番詳しい」「この地域のことはこの会社に聞けば間違いない」という圧倒的なポジションをデジタル空間上で確立することを目指す戦略です。

AIからの信頼を独占する先行者利益

構造化データを完璧に実装し、一次情報を発信し続け、エンティティとしての信頼性を高めきった企業は、AI検索エンジンにとって「唯一無二の正解データ」となります。ユーザーがその分野についてAIに質問したとき、回答のソースとして常に自社の名前が表示される状態になります。

AI検索の世界では、従来の検索結果のように1ページ目に10個のサイトが並ぶことは少なくなります。AIは「ベストな回答」をひとつ、あるいは数個だけ提示します。つまり、1位のサイトがユーザーの関心を総取りし、2位以下のサイトにはほとんど光が当たらないという現象が起こります。この「勝者総取り」のポジションを獲得できれば、広告費をかけずとも、質の高い見込み客が自動的に集まり続ける仕組みが完成します。リニューアルにかかる初期費用や運用の手間は大きいですが、得られるリターンもまた、従来とは比較にならないほど大きなものになります。

業界のトップランナーとしてのブランディング

AIに選ばれるということは、客観的な技術力と情報品質において、その企業が優れていることの証明でもあります。ユーザーは「AIが勧めるのだから、ここはしっかりした会社なのだろう」という印象を抱きます。これは単なる集客効果を超えて、企業ブランドの価値向上に直結します。人材採用や取引先からの信用獲得においても、プラスの影響を与えるはずです。

低予算で形式的な運営に留める道

もうひとつの選択肢は、Web集客に見切りをつけるという判断です。「自社の事業規模や予算では、高度なGEO対策を継続するのは難しい」と冷静に判断し、ホームページの役割を限定する戦略です。

ホームページは「デジタルな名刺」と割り切る

この場合、ホームページで新規顧客を集めようとは考えません。ホームページの役割は、すでに自社のことを知っている人(既存客や、チラシ・紹介などで名前を知った人)が、住所や電話番号、営業時間を確認するためだけの「デジタルな名刺(会社案内)」として機能すれば十分とします。

無理にブログを更新したり、複雑なシステムを導入したりする必要はありません。その代わり、デザインは清潔感のあるものにし、情報は常に最新の状態に保つことだけを心がけます。リニューアルの費用も最小限に抑え、浮いた予算を他の施策に回します。

他の集客チャネルへの資源集中

Webでの集客を諦める代わりに、SNS(InstagramやXなど)でのコミュニケーションに特化したり、Googleマップ(MEO)の口コミ対策に注力したり、あるいはアナログなチラシや対面営業を強化したりします。すべての企業がAI検索で勝負しなければならないわけではありません。自社の強みが活きる土俵で戦うために、あえてWebという戦場からは撤退するというのも、立派な経営戦略です。

「中間の層」が消滅する理由

最も危険なのは、上記二つのどちらでもない「中途半端な層」です。これまでは、「そこそこの予算」でリニューアルし、「月に1回程度」ブログを更新していれば、ある程度の検索流入が見込めました。検索結果の1ページ目(10位以内)に入れば、それなりのアクセスがあったからです。

2番手以下の情報はAIに無視される

しかし、AI検索時代において「検索結果の8位」や「検索結果の5位」といった順位には、ほとんど価値がなくなります。AIはユーザーに対し、膨大な情報の中から最適解を抽出して提示します。「そこそこ良い情報」や「可もなく不可もない情報」は、AIの回答生成プロセスにおいて切り捨てられてしまうからです。

コストをかけてリニューアルし、スタッフが時間を割いてブログを書いているのに、AIにも選ばれず、人間にも見られない。これでは、Web運営にかかる費用はすべて「無駄金」になってしまいます。これからリニューアルを検討する際には、「トップを狙う」のか、それとも「戦わない」のか。この方針を明確にしないまま、従来の慣習でプロジェクトを進めることだけは避けなければなりません。

未来に向けたホームページ制作・リニューアルの選択

AI検索時代(GEO)におけるホームページリニューアルのあり方について解説してきました。

私たちが直面しているのは、単なる検索エンジンの仕様変更ではありません。インターネットという巨大な図書館の「司書」が、これまでの「キーワード検索システム」から、「高度な知能を持つAI」へと交代したのです。新しい司書は、本の内容を深く理解し、著者の信頼性を厳しくチェックし、そして本当に読む価値のある本だけを利用者に勧めます。

これからのホームページリニューアルは、人間が見て美しいデザインを作るだけでは不十分です。新しい司書であるAIに対して、自社の情報を正しくプレゼンテーションするための「システム的なアップデート」が必要になります。構造化データの実装、セマンティックなコード記述、一次情報の体系化といった技術的な取り組みは、まさにAIとの対話そのものです。

技術的な難易度は確かに上がっています。しかし、それは裏を返せば、正しく取り組むことで競合他社に圧倒的な差をつけるチャンスでもあります。多くの企業がまだGEOの重要性に気づいていない今こそが、先行者利益を獲得する絶好の機会です。

自社の事業は、AI検索という新しいインフラの上で、どのように存在感を示していくべきか。 リニューアルという機会を通じて、ぜひその根本的な問いに向き合ってみてください。 積極的なGEO対策を行い、AIと共に成長する未来を選ぶか。それとも、Web以外に活路を見出すか。どちらの道を選ぶにせよ、その決断が事業の未来を拓く第一歩となるはずです。

この投稿が、あなたのホームページリニューアル、そしてその先の事業発展の一助となれば幸いです。

(初回投稿日 2025年12月19日)